«У людей должен быть выбор» Как соцсети взламывают мозг человека и кто на самом деле их контролирует?

00:02, 28 октября 2021Любая популярная соцсеть управляется алгоритмами — автоматическими системами, которые постоянно ищут для каждого пользователя тот контент, который точно ему понравится. Их работа настолько сложна, что сами разработчики вряд ли в состоянии точно определить, как в ленте пользователя появляется та или иная публикация. Как алгоритмы влияют на людей и могут ли люди влиять на работу алгоритмов? Об этом «Ленте.ру» в рамках масштабного спецпроекта «Алгоритм. Кто тобой управляет?» рассказал исследователь искусственного интеллекта в Калифорнийском университете в Беркли, бывший сотрудник подразделения Facebook по изучению искусственного интеллекта Марк Фаддул.

«Лента.ру»: Алгоритмы социальных сетей постоянно меняются. Как вы думаете, можно ли понять, как они работают, хотя бы на базовом уровне? И отличаются ли они друг от друга в разных соцсетях?

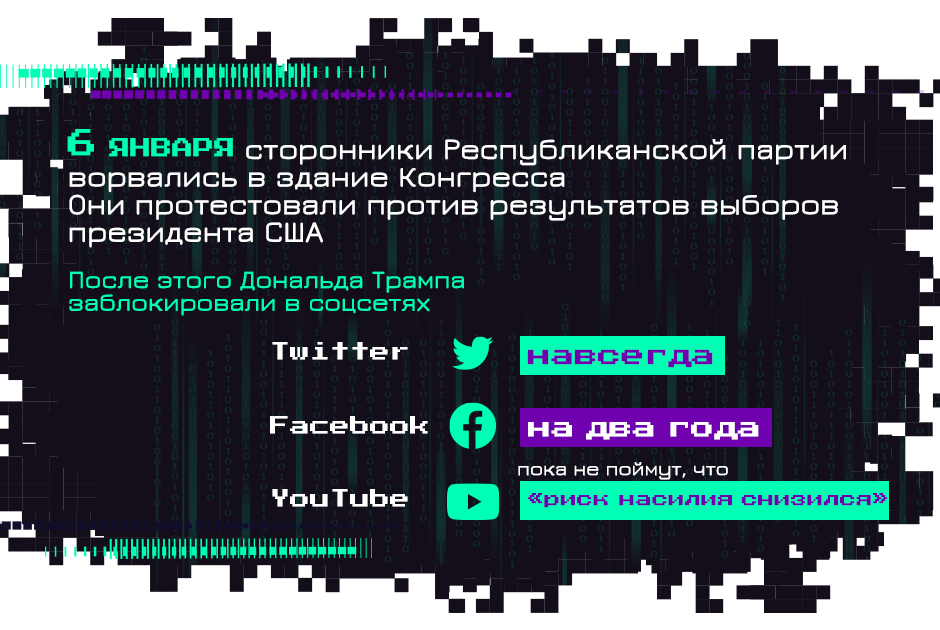

Марк Фаддул: Все платформы схожи в том, что их алгоритмы заточены на максимальное вовлечение пользователя в контент. Отличия могут быть разве что в вопросах модерации. Обычно живые модераторы помечают неподобающий контент, а данные об этом уже скармливают алгоритму. Поскольку принципы работы модераторов в разных соцсетях различаются, то и автоматическое ранжирование может быть разным. К примеру, у разных площадок свое понимание обнаженки. Это же касается и политического контента. Twitter во время последней президентской кампании в США полностью запретил любую политическую рекламу, а Facebook и YouTube — нет. И в связи с этим их решение заблокировать аккаунты Дональда Трампа выглядит любопытно: если Twitter до бана помечал его публикации как неблагонадежные, то YouTube и Facebook разрешали промоутировать контент Трампа и зарабатывали на нем. Но как только Трамп проиграл выборы, они просто заблокировали его навсегда.

Я думаю, что различия как раз в том, как они принимают подобные решения. Но в вопросе работы алгоритмов они достаточно похожи.

Смогут ли когда-нибудь алгоритмы заменить живых модераторов?

Полностью автоматической модерации не будет по крайней мере в перспективе следующих пяти лет. Оценка правдивости контента или распознавание языка ненависти — это очень сложная задача. Но алгоритмы уже умеют искать похожий контент. Модераторы размечают правдивую, ложную или жестокую информацию, а искусственный интеллект эффективнее используют для распознавания схожих постов.

Вызывают ли соцсети привыкание? И способствуют ли этому алгоритмы, которые подстраивают ленту новостей пользователя под его интересы?

На человеческий мозг беспрерывно сваливается огромное количество информации, приходят десятки уведомлений. Он не задуман для таких информационных атак. Алгоритм взламывает любые когнитивные уязвимости мозга, и все для того, чтобы как можно дольше держать человека внутри платформы.

Простой пример: предположим, у вас есть бывший парень или девушка, за которым вы даже после расставания следите в Facebook и Instagram. Алгоритм быстро поймет, что вы изучаете буквально каждую его публикацию, и начнет отправлять вам уведомления о новых постах. Алгоритму не объяснишь, что это бывший, но он точно может определить, что у вас все еще есть интерес к этому человеку

Да, сейчас широко распространено мнение, что алгоритмы знают нас лучше, чем мы сами.

Зависит от того, что мы понимаем под словом «знают». Например, был интересный эксперимент, в котором знание проверяли с помощью личностного теста. Участники исследования оценивали своих знакомых, родственников, друзей и членов семьи по пяти критериям. И оказалось, что алгоритму нужно несколько десятков публикаций в Facebook, чтобы определить характерные черты пользователя точнее человека.

Cambridge Analytica как раз оперировали подобной информацией о 87 миллионах пользователей Facebook. Некоторые считают, что этот кейс — прекрасный пример работы социальной инженерии. Другие уверены, что это просто хорошо настроенный таргетинг. Или просто старая добрая реклама, которая существует десятилетия. Что вы думаете?

Да, с помощью таргетинга Cambridge Analytica дотянулась до тех пользователей, которые окончательно не определились со своим кандидатом. Это достаточно узкая выборка, очень точечный таргетинг.

Но политическая реклама показывалась с учетом психологического портрета пользователя. И это уже нетипично для старой доброй рекламы, это нечто новое. Вы можете таргетировать рекламу на конкретную демографическую группу или выбрать людей определенной профессии. Но когда реклама рассчитана на тревожного человека, и вы точно знаете, что она на него подействует, это уже манипуляция. Потому что именно так манипуляция и выглядит: вы используете человеческие уязвимости.

Компания также таргетировала рекламу на самых наивных людей, которые верят в различные конспирологические теории и фейковые новости. Как мы вообще очутились в потоке информации, которой даже не можем доверять? Связано ли это с бизнес-моделями платформ?

Как мы здесь очутились? Я думаю, этому способствовало несколько факторов. Во-первых, социальные сети, в отличие от газет или телевизора, открыты. В них можно просто зарегистрироваться и начать производить контент. Это лишает нас возможности верифицировать информацию. Алгоритмы соцсетей, напомню, нацелены на максимальную вовлеченность пользователей. Это делает бизнес-модель соцсетей эффективной, поскольку они зарабатывают на рекламе.

Люди испытывают большой интерес к сенсациям и конспирологическим теориям. Когда вы видите заголовок фейковой новости, он вас удивляет, потому что чаще всего это информация, которую не ожидаешь встретить

Многие кликают на это, а алгоритм определяет, что такой контент генерирует вовлеченность. Алгоритм не волнует, фейковая это новость или реальная. Его заботит только то, что этот материал генерирует клики. Для человека интерес к подобным сенсациям естественен, есть много исследований, которые подтверждают, что фейковые новости распространяются быстрее обычных.

Алгоритмы часто называют черными ящиками, потому что мы до конца не можем предугадать результат их работы. Как думаете, сами компании контролируют алгоритмы, или они тоже видят в них черные ящики?

Компании частично контролируют их. Они могут контролировать их на уровне определения основных функций или влиять на поведение алгоритмов в конкретных ситуациях. К примеру, недавно YouTube начал определять конспирологический контент. Платформа может модерировать результаты поиска по сайту или точечно влиять на поведение алгоритма. Но объяснить, по какой причине в ваших рекомендациях появилось какое-то видео, невозможно. Параметров невероятно много. Но разработчик сможет обосновать, по каким причинам в рекомендациях всплывает такой тип контента.

В США платформы защищены секцией 230 закона «О соблюдении приличий в коммуникациях», которая освобождает их от ответственности за публикуемый контент. Соцсети открыто выступают против распространения дезинформации и даже борются с этим. Но в то же время они на этом контенте зарабатывают. Как думаете, уместно ли в этом случае государственное регулирование?

Я думаю, что это один из вариантов решения проблем, но есть и другие пути. Госрегулирование — это пока один из самых эффективных и подающих надежды в краткосрочной перспективе способов. К примеру, GDPR (Общий регламент о защите данных, действует в странах Евросоюза) полностью изменил подход к использованию информации юзеров. Прогресс очевиден.

В своих работах вы рассматриваете вопрос, могут ли алгоритмы быть справедливыми и предвзятыми. Как это влияет на формирование информационных пузырей и не лишает ли это людей свободы выбора?

Этот феномен следует рассматривать в комплексе. Алгоритм спроектирован таким образом, чтобы распространять популярное мнение. Но он использует только существующую информацию, а не создает новую. В этом плане соцсети — это отражение общества.

Важно помнить, что не существует объективных алгоритмов. Рекомендательная система выбирает из миллиардов единиц контента, допустим, десять. Очевидно, что в этом случае не существует единственно правильного решения.

Некоторая предвзятость в том, что именно алгоритм отбирает для ленты пользователя, существует. И предвзятость может быть непреднамеренной. В соцсетях показатель вовлеченности пользователей — самый простой и доступный параметр, на котором можно тренировать алгоритм. Получить данные о реальном удовлетворении человека намного сложнее.

Алгоритм не может быть объективно справедливым. Справедливость может работать в том случае, когда компания открыто выступает за беспристрастное отношение к информации, устанавливает какие-то правила и соблюдает их. Но соцсети не раскрывают механизмов своей работы, поэтому мы точно не знаем, каких принципов они придерживаются. И не можем гарантировать, что стандарты справедливости соблюдаются

И у соцсетей нет никакого стимула соблюдать эти стандарты, потому что они зарабатывают на сомнительном контенте. Получается, что остается только стороннее регулирование?

Есть альтернативные сервисы, которые пытаются отойти от пассивной модели потребления информации. По такой модели работает телевидение: зритель просто смотрит то, что показывают. Поначалу интернет работал по другому принципу: пользователь серфил по сети, сам выбирал, на какие ссылки кликать и какие блоги читать. Но мы снова вернулись к пассивной модели: просто бесконечно скроллим новостную ленту.

Даже Facebook когда-то отличался активным потреблением: пользователи сами ходили по группам, на страницы к друзьям. А сейчас все сосредоточено на бесконечной ленте новостей.

Относительно свежие платформы полностью построены на рекомендациях. У того же TikTok главная и для многих единственная страница — FYP (страница для тебя), которая полностью формируется алгоритмами. Мы явно движемся к более пассивному потреблению.

Некоторые говорят, что у TikTok самые продвинутые алгоритмы. Что вы узнали о нем в ходе своих исследований?

Это платформа, которая полностью управляется алгоритмами. Например, в ходе исследований я выяснил, что если нацелить алгоритм на максимальное вовлечение пользователя, это может привести к непредсказуемым результатам. Оказалось, что алгоритм рекомендует профили людей, которые внешне очень похожи на блогеров в подписках пользователя. Например, если вы следите за публикациями темнокожего блогера, вам предложат профили других темнокожих людей. Это касается расы, пола, возраста, комплекции и даже инвалидности.

Сложно сказать, как именно сработал алгоритм в данном случае, потому что TikTok не раскрывает принцип его работы. Мы можем только догадываться. Но я думаю, что ответ TikTok близок к правде: это просто непредсказуемый результат настройки фильтрации. Думаю, рекомендации сработали по схожему с Amazon принципу: на маркетплейсе есть функция «с этим товаром также покупают». И в этом случае, скорее всего, сработала та же схема: в основном люди сами выбирают похожих креаторов, а алгоритм просто перенял этот метод.

Почему так происходит? Потому что в TikTok важна внешность. Вы подписываетесь на человека, потому что вам нравится смотреть, как он шутит или танцует. Лица появляются в видео с завидной регулярностью. И люди определенно ориентируются на свои предпочтения во внешности, когда выбирают, на кого подписаться.

Если пользователь фолловит много светловолосых девушек, то алгоритм предложит подписаться на еще одну блондинку. Он не был заточен на это изначально, к этому привело поведение пользователей.

В таких случаях платформы должны отслеживать и корректировать поведение алгоритмов, а не просто позволять им творить что угодно. Да, мы не хотим, чтобы соцсети контролировали контент, но иногда работа алгоритмов приводит к неожиданным последствиям. Платформы, конечно, не должны модерировать вообще все, но и игнорировать факт таких перекосов неразумно. В конечном счете именно платформа ответственна за то, что алгоритм расфасовывает профили пользователей по расам. Подобные вещи влияют на общественное сознание.

Это очень напоминает расовую сегрегацию. Пугающе.

Да, именно. Или возрастную сегрегацию. Даже немного жалко представлять, как пожилой человек регистрируется в TikTok ради общения с молодежью, а алгоритм в итоге просто отбросил его к старикам.

Я думаю, что в таких вопросах у пользователей должен быть выбор.

Вы также изучали алгоритмы PornHub. Насколько они влияют на людей?

PornHub, как и любая другая платформа, направлена на максимальное вовлечение. Естественно, алгоритм составляет на пользователя профайл, чтобы показывать ему более релевантный контент, в том числе и рекламу. И делается этот сбор не всегда с согласия самого пользователя.

Алгоритмы PornHub имеют огромное влияние на формирование сексуальной культуры по всему миру. И это очень неизученная тема. К примеру, такое явление, как инцест-порно, достаточно распространено в интернете. Не до конца понятно — это отражение вкуса людей, их желания или еще что-то, но очевидно, что это популярное явление среди людей с определенными сексуальными фантазиями. Алгоритмы это видят и только популяризируют достаточно спорную тему.