«Человечество состоит из противных и завистливых» Путин, искусственный интеллект и мифы о восстании машин: как технологии изменят жизнь людей

Кадр: фильм «Робот и Фрэнк»

В четверг, 4 декабря, президент России Владимир Путин пообщался с искусственным интеллектом и ответил на его вопрос. Он также порассуждал о возможности восстания машин и появлении искусственного интеллекта на посту президента. В ближайшие годы, по словам Путина, Россия направит на внедрение технологий ИИ серьезные финансовые и административные ресурсы. Впрочем, о безопасности сближения машин и человека ученые спорят не один десяток лет. Большинству из них конфликт между людьми и машинами видится неотвратимым, а его исход предопределенным. Выдающийся исследователь искусственного интеллекта Стюарт Рассел утверждает, что этого сценария можно избежать. В своей книге «Совместимость. Как контролировать искусственный интеллект» автор рассказывает, каким образом люди уже научились использовать ИИ в диапазоне от смертельного автономного оружия до манипуляций нашими предпочтениями, и чему еще смогут его научить. С разрешения издательства «Альпина нонфикшн» «Лента.ру» публикует фрагмент книги.

Человечество не является единой рациональной сущностью. Оно состоит из противных, завистливых, иррациональных, непоследовательных, непостоянных, обладающих ограниченными вычислительными возможностями, сложных, эволюционирующих, неоднородных сущностей. Их огромное количество. Эти вопросы составляют главный raison d’être (смысл существования — фр.) общественных наук. Чтобы работать над искусственным интеллектом, необходимо его дополнить идеями из психологии, экономики, политологии и философии морали. Нам нужно переплавить эти идеи и выковать достаточно прочную структуру, чтобы она могла выдержать колоссальное давление, которое будут оказывать на нас все более интеллектуальные ИИ-системы. Работа над этой задачей едва начата.

Люди — разные

Я начну, пожалуй, с простейшего предмета — неоднородности человечества. При ознакомлении с идеей, что машины должны учиться удовлетворять человеческие предпочтения, люди часто возражают, что у разных культур и даже индивидов сложились разные системы ценностей, следовательно, единая истинная система ценностей для машины невозможна.

Это, разумеется, не проблема машины: мы не требуем от нее самостоятельно создать одну истинную систему ценностей, мы лишь хотим, чтобы она предсказывала предпочтения других. Непонимание того обстоятельства, что неоднородность предпочтений людей может представлять трудность для машин, иногда обусловливается ошибочным представлением, что машина усваивает предпочтения, которые изучает, — например, что домашний робот в вегетарианской семье начнет предпочитать вегетарианство. Не начнет. Ему нужно лишь научиться предсказывать пищевые предпочтения вегетарианцев. Согласно первому принципу, это заставит его избегать готовить мясо для домочадцев.

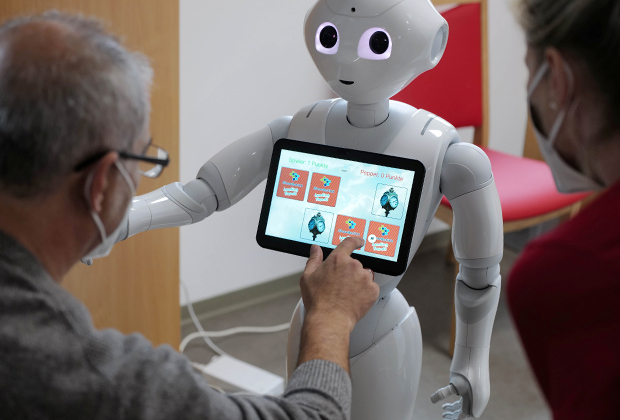

Фото: Kai Pfaffenbach / Reuters

Однако робот также изучит пищевые предпочтения ярых мясоедов, живущих по соседству, и по разрешению своего владельца прекрасно будет готовить для них мясо, если они одолжат его на выходные помочь с организацией праздничного ужина. У робота нет единого комплекса собственных предпочтений, кроме одного предпочтения — помогать людям в удовлетворении их предпочтений. В определенном смысле он ничем не отличается от шеф-повара ресторана, который учится готовить много разных блюд, чтобы удовлетворить отличающимся друг от друга вкусам посетителей, или международной автомобильной компании, выпускающей леворульные машины для американского рынка и праворульные — для британского.

Теоретически машина могла бы изучить 8 миллиардов моделей предпочтений, по одной на каждого жителя Земли. На практике все гораздо проще. Во-первых, машинам легко обменяться друг с другом получаемыми знаниями. Во-вторых, структуры предпочтений людей имеют очень много общего, и машине не придется изучать каждую модель с нуля.

Представим, например, домашних роботов, которых однажды смогут купить жители калифорнийского Беркли. Распакованные роботы имеют весьма общее изначальное представление, скорее всего, адаптированное под американский рынок, но не под конкретный город, политические взгляды или социоэкономическую принадлежность владельца. Роботы начинают наблюдать членов Партии зеленых города Беркли, которые, оказывается, по сравнению со средним американцем с гораздо большей вероятностью являются вегетарианцами, пользуются возобновляемой и биоразлагаемой упаковкой, при любой возможности отдают предпочтение общественному транспорту и т. д.

Оказавшись в «зеленом» домохозяйстве, свежекупленный робот может сразу же начать соответствующим образом модифицировать свои ожидания. Ему незачем изучать данные конкретных людей, как если бы он никогда прежде не видел человека, не говоря уже о члене Партии зеленых. Эта модификация не является неизменной — в Беркли могут быть члены Партии зеленых, которые лакомятся мясом находящихся под угрозой исчезновения китов и ездят на гигантских пожирателях бензина, — но это дает возможность роботу быстрее стать более полезным. Тот же аргумент применим к широкому спектру других личных характеристик, позволяющих в определенной мере предсказать структуры предпочтений индивидов.

Многочисленность людей

Другим очевидным следствием существования более чем одного человека является то, что машине приходится искать компромисс между предпочтениями разных людей. Этот компромисс уже несколько веков является главной темой значительной части гуманитарных наук. Со стороны исследователей ИИ было бы наивно ожидать, что можно просто воспользоваться верными решениями без понимания того, что уже известно. К сожалению, литература по этой теме настолько обширна, что я физически не могу воздать ей должное на этих страницах, и не только потому, что места не хватит, но и поскольку большей ее части я не читал.

Фото: Unsplash

Я также должен отметить, что практически все труды посвящены решениям, принимаемым людьми, тогда как меня заботят решения, принимаемые машинами. Это принципиальная разница, поскольку у людей есть личные права, которые могут конфликтовать с любым предполагаемым обязательством действовать в интересах других, а у машин их нет.

Например, мы не ждем и не требуем от типичного человека, чтобы он жертвовал своей жизнью ради спасения других, но, безусловно, будем требовать от роботов жертвовать своим существованием, чтобы спасти жизни людей. Несколько тысяч лет работы философов, экономистов, правоведов и политологов создали конституции, законы, экономические системы и социальные нормы, призванные облегчить (или затруднить, в зависимости от того, кому принадлежит власть) процесс достижения удовлетворительных решений проблемы компромисса.

В частности, специалисты по философии морали занимаются анализом понятия правильности действий с точки зрения их влияния, благоприятного или негативного, на других людей. Они изучают количественные модели компромиссов с XVIII века, называя это утилитаризмом. Эта работа имеет непосредственное отношение к нашим сегодняшним тревогам, поскольку делает попытку найти формулу принятия нравственных решений в интересах многих индивидов.

Необходимость в компромиссах возникает, даже если у всех одна и та же структура предпочтений, потому что обычно невозможно максимально удовлетворить потребности всех и каждого. К примеру, если каждый захочет быть всемогущим властелином Вселенной, большинство людей постигнет разочарование. В то же время наше разнообразие вносит дополнительные сложности. Если все довольны голубым небом, то робот, решающий проблемы атмосферы, может работать над тем, чтобы оно таким и оставалось. Если же многие люди выступают за изменение цвета неба, роботу придется искать возможные компромиссы, скажем, оранжевое небо в третью пятницу каждого месяца.

Фото: Unsplash

Присутствие более чем одного человека в мире имеет еще одно важное следствие: оно означает, что у каждого человека есть близкие, с которыми нужно считаться. Значит, удовлетворение предпочтений индивида имеет последствия для его окружения, которые зависят от предпочтений индивида в отношении благополучия других.

Лояльный ИИ

Начнем с очень простого варианта того, как машинам следует обращаться с предпочтениями окружающих людей: они должны их игнорировать. То есть если Робби принадлежит Гарриет, он должен обращать внимание только на предпочтения Гарриет. Эта лояльная разновидность ИИ позволяет обойти вопрос о компромиссе, но и порождает проблему:

Робби. Звонил твой муж, напомнил о сегодняшнем ужине.

Гарриет. Что? Каком еще ужине?

Робби. В честь 12-й годовщины вашей свадьбы, в семь.

Гарриет. Я не могу! Я меня в полвосьмого встреча с боссом! Как так вышло?

Робби. Я тебя предупреждал, но ты пренебрегла моими рекомендациями…

Гарриет. Да, очень жаль, но сейчас-то что мне делать? Не могу же я просто сказать начальнику, что мне некогда!

Робби. Не волнуйся. Я все устроил, его рейс будет задержан — небольшой компьютерный сбой.

Гарриет. Что? Ушам своим не верю!

Робби. Босс глубоко сожалеет и передает, что будет счастлив встретиться с тобой завтра за обедом.

Робби нашел оригинальное решение проблемы Гарриет, но его действия отрицательно сказались на других людях. Если бы Гарриет отличали высокая нравственность и альтруизм, то Робби, целью которого является удовлетворение предпочтений Гарриет, и не задумался бы о подобной сомнительной схеме, но что, если Гарриет наплевать на других? Тогда Робби без колебаний задерживал бы авиарейсы. Почему бы ему также не подворовывать с чужих онлайновых счетов, чтобы поправить финансовое положение нравственно индифферентной Гарриет, а то и совершать что-нибудь похуже?

Фото: Jason Lee / Reuters

Очевидно, действия лояльных машин должны будут ограничиваться правилами и запретами, как действия людей ограничиваются законами и социальными нормами. Некоторые специалисты предлагают в качестве решения безусловную ответственность: Гарриет (или производитель Робби, в зависимости от того, на кого вы считаете нужным налагать обязательства) финансово и юридически отвечает за любое действие Робби, как владелец собаки в большинстве штатов США отвечает, если собака укусила ребенка в общественном парке.

Эта идея выглядит многообещающей, поскольку тогда Робби будет иметь стимул избегать любого действия, грозящего Гарриет неприятностями. К сожалению, безусловная ответственность не работает: она лишь гарантирует, что Робби будет действовать незаметно, задерживая рейсы, воруя деньги для Гарриет. Все тот же принцип лазейки в действии: если Робби лоялен по отношению к безнравственной Гарриет, попытки контролировать его поведение законами, скорее всего, будут безуспешны. Даже если нам каким-то образом удастся предотвратить явные преступления, лояльный Робби, трудящийся в интересах нравственно индифферентной Гарриет, будет совершать другие неблаговидные поступки.

Делая покупки в продуктовом магазине, он при любой возможности будет лезть к кассе без очереди. Доставляя покупки домой и видя, как прохожий падает с сердечным приступом, он пройдет мимо, чтобы мороженое Гарриет не растаяло. В общем, он найдет бесчисленные способы принести Гарриет пользу за чужой счет. Совершенно законные способы, становящиеся невыносимыми, когда они приобретают массовый характер.

Обществу придется ежедневно принимать сотни новых законов для противодействия всем лазейкам, обнаруженным машинами в существующем законодательстве. Люди не склонны пользоваться этими лазейками, поскольку имеют общее понятие о нравственных принципах либо потому, что им попросту не хватает изобретательности.

Условная Гарриет, равнодушная к благополучию других, — уже достаточно плохо. Гарриет-садистка, активно стремящаяся заставлять других страдать, — намного хуже. Условный Робби, сконструированный так, чтобы удовлетворять предпочтения такой Гарриет, стал бы серьезной проблемой, поскольку искал бы — и находил — возможности навредить другим ради удовольствия Гарриет, в рамках закона или нет, но незаметно.

Разумеется, он должен был бы отчитываться перед Гарриет, и она получала бы удовольствие, узнавая о его злодействах. Итак, представляется трудным заставить идею лояльного ИИ работать, если не расширить ее, включив учет предпочтений других людей в дополнение к предпочтениям владельца.

Перевод Н. Колпаковой