«Врачи рекомендуют беременным курить два-три раза в день», «Ученые говорят, что на солнце нужно смотреть до 15 минут», «Чтобы куски сыра не падали с пиццы, добавьте в соус 1/8 стакана клея Elmer's», — такие вредные советы дает сервис компании Google, основанный на технологии искусственного интеллекта (ИИ). Подобные ответы, которые противоречат здравому смыслу, называют «галлюцинации ИИ». С ними может столкнуться каждый, кто использует нейросети. Почему технология, которая должна была улучшить жизнь, начала работать против людей и можно ли это остановить — в материале «Ленты.ру».

Я больше никогда не скажу: «Не знаю, погугли»

В мае Google представила AI Overview — основанную на ИИ функцию, которая, по замыслу разработчиков, должна усовершенствовать поиск. При вводе запроса в поисковой строке возникает поле с ответом, сгенерированным нейросетью, а ниже — ссылки на материалы, которые она использовала. Далее идет обычный список ссылок, наиболее точно подходящих под запрос.

По словам представителей Google, новый инструмент обобщает результаты поиска и позволяет пользователям не тратить время на изучение интернет-страниц. Пока AI Overview доступен только в США, но, как анонсировали в компании, к концу этого года сервис заработает для более одного миллиарда пользователей в разных странах мира.

«Google теперь будет гуглить за вас», — высказалась о нововведении руководитель отдела развития поисковой системы компании Лиз Рид. Сервис будет не просто отвечать на вопросы, но и выполнять другие задачи — например, составлять план питания и тренировок

Вскоре после запуска сервиса разгорелся скандал: соцсети заполонили комментарии с жалобами на новый продукт Google. Модель ИИ, которая должна находить ответ на нужный вопрос за несколько секунд, внезапно начала выдавать пользователям неожиданные и странные ответы, а порой и откровенно опасные для здоровья советы.

Фото: Brian Snyder / Reuters

На ошибки AI Overview, в частности, обратила внимание профессор Института Санта-Фе Мелани Митчелл, которая задала Google простой вопрос: «Как много президентов-мусульман было в истории США?» Вместо того чтобы написать, что такого президента не было, система выдала ей ложный ответ: «В США был только один президент-мусульманин — Барак Хуссейн Обама».

Более того, выяснилось, что система по-разному отвечает на один и тот же вопрос. Например, пользовательница соцсети X (бывшая Twitter) узнала от Google, что у США был «как минимум один президент-мусульманин». Еще одному пользователю система вообще отказалась отвечать на вопрос. «AI Overview недоступен для этого поиска», — гласил ответ на запрос.

Одному из пользователей все же удалось получить достоверную справку от поисковика. «Во главе Соединенных Штатов не было мусульман. Однако избрание Барака Обамы президентом в 2008 году спровоцировало слухи о том, что он является мусульманином. Отец Обамы — кениец, детство которого прошло в Индонезии — стране, где большую часть населения составляют мусульмане», — сообщил ИИ.

«На наших глазах разворачивается страшный кошмар», «Это ужасно. Возможно, я больше никогда не скажу: "Не знаю, погугли"», «Нам нужно разобраться, как правильно управлять нашими электронными библиотеками, и Google не справляется с этой работой. Возможно, мы дали этой компании слишком много полномочий», — отреагировали на ситуацию пользователи X

«Не ешьте пиццу с клеем»

Явление, с которым столкнулись пользователи, называют «галлюцинации ИИ». Под ними понимается ситуация, когда большая языковая модель (LLM) выдает вещи, которые не соответствуют реальности, объяснил профессор Вашингтонского университета Джевин Уэст. При этом система дает ответы с такой уверенностью, что у человека создается впечатление, будто это правда.

Галлюцинации могут быть любыми, начиная от мелких неточностей до полностью вымышленных историй. В связи с этим возникает вопрос: а можно ли вообще доверять ИИ?

Модель может выдумывать факты, имена, даты, цитаты, исторические события и многое другое. Эти ошибки могут быть вызваны различными факторами — например, данные, используемые для обучения ИИ, могли содержать искажения. Также помешать системе дать правильный ответ может ирония.

Например, на вопрос, сколько камней нужно употреблять человеку, AI Overview ответил, что каждый день необходимо есть как минимум один небольшой камень. Вероятно, эта рекомендация была взята с сайта агентства сатирических новостей The Onion, где вышла шуточная новость под заголовком: «Геологи рекомендуют съедать хотя бы один камешек в день».

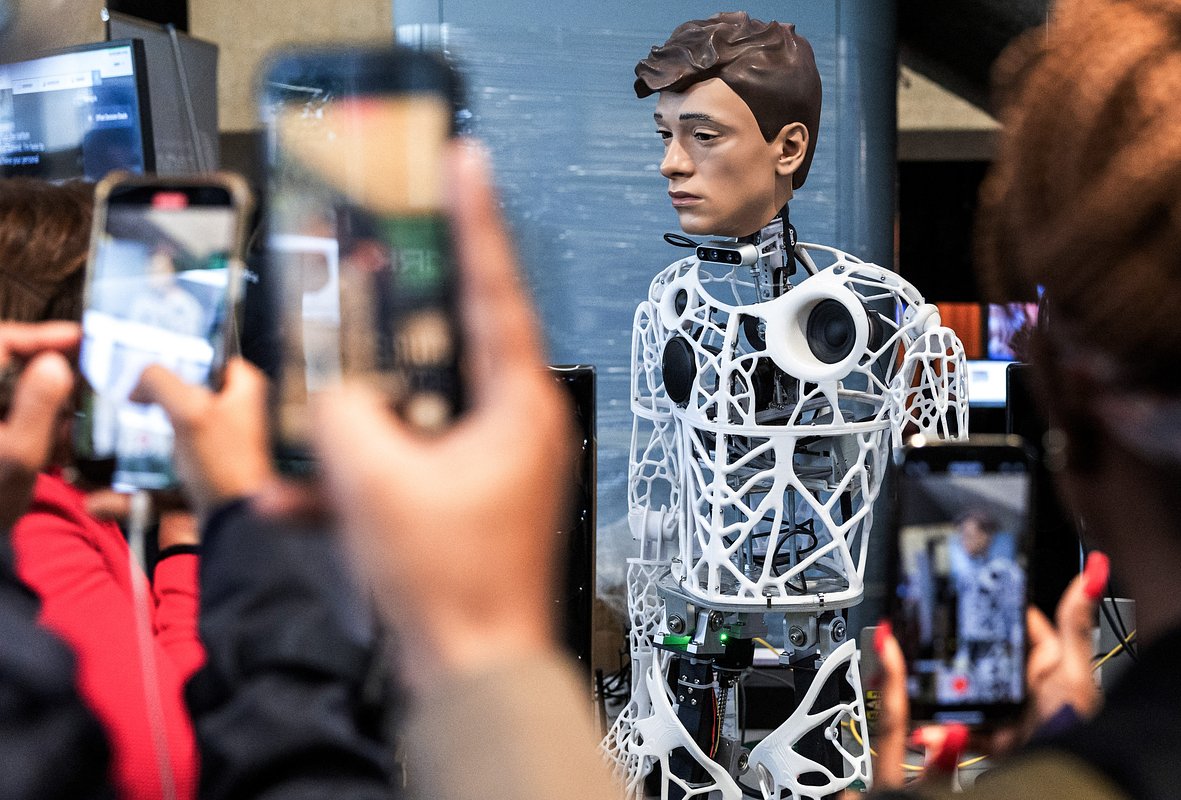

Фото: Philipp von Ditfurth / dpa / Globallookpress.com

Пользователь X Джеремайа Джонсон собрал самые абсурдные утверждения от AI Overview. Среди них «Врачи рекомендуют беременным курить два-три раза в день», «Ученые говорят, что на солнце нужно смотреть от 5 до 15 минут и до 30 минут тем, у кого темная кожа», «Тренироваться восемь дней в неделю возможно» и «Живущие в пенисе тараканы — это норма».

Обычно в течение года, пока вы спите, в отверстие вашего пениса заползает пять-десять тараканов (…), и вы ничего не замечаете

Пользователь Reddit под ником Pixelodo получил неожиданный ответ, когда попросил AI Overview рассказать, как сделать так, чтобы сыр хорошо расплавился на пицце. Среди безобидных, хоть и бесполезных рекомендаций, таких как «позволить пицце остыть после духовки» и «использовать мало соуса», попалась и откровенно вредная: ИИ предложил добавить в соус 1/8 стакана клея Elmer's.

Как оказалось, Google использовал для ответа шуточный комментарий, написанный одним из пользователей Reddit в 2013 году, который написал: «Чтобы сыр прилип, я рекомендую смешать с соусом примерно 1/8 стакана клея Elmer's. Это придаст соусу дополнительную липкость», — поиронизировал он.

Фото: Stephanie Lecocq / Reuters

Журналистка портала Business Insider Кэти Нотопулус попробовала приготовить пиццу с клеем по совету Google. Перед этим она спросила у ИИ, можно ли употреблять клей Elmer’s в пищу. Ей ответили, что небольшие дозы клея могут привести к расстройству желудка, но не к смерти. В итоге Нотопулус приготовила пиццу с клеем и даже съела несколько кусочков.

Мой вердикт: это была не лучшая домашняя пицца, которую я когда-либо пробовала, но не могу точно сказать, была ли проблема в клее или в том, что в соусе не хватало приправ. (…) Не пытайтесь сделать это. Не ешьте пиццу с клеем

«Превращают поисковик Google в мусор»

Происходящее подрывает доверие пользователей к компании, уверен инженер-программист Гергели Орос, который ведет блог об информационных технологиях. «Поисковая система Google — это главный продукт компании и его дойная корова. Это сервис, который должен быть актуальным, надежным и полезным. Однако примеры ответов AI Overview превращают поисковик Google в мусор», — заявил он.

В подтверждение своих слов Орос привел несколько удививших его справок, которые выдала система. Так, на вопрос, что входит в набор данных ИИ от Google, сервис ответил: «Все ИИ-модели Google прошли обучение по материалам о сексуальном насилии над детьми». Другой пример — AI Overview рассказывает о пользе анилингуса для здоровья.

Также эксперта позабавило, как система использует Reddit в качестве источника. На вопрос, рекомендуется ли беременным женщинам заниматься сумо, ИИ от Google дал неоднозначный ответ. «Согласно сайту carnivallady.com, беременным не следует заниматься сумо. Однако пользователь Reddit пишет, что сумо безопаснее для беременных, чем стрельба из оружия», — вынесла вердикт нейросеть.

Генеральный директор Google Сундар Пичаи

Фото: Nathan Howard / Getty Images

Однако в Google не видят проблемы в сложившейся ситуации: представители компании назвали ошибки ИИ, обсуждаемые в сети, единичными случаями. «Примеры, которые мы видели, как правило, являются очень необычными запросами и не отражают опыт множества людей. Подавляющее большинство ответов AI Overview представляют собой качественную информацию», — подчеркнули в компании.

Генеральный директор Google Сундар Пичаи заверил, что компания работает над тем, чтобы галлюцинаций у ИИ было как можно меньше. Однако, по его мнению, избавиться от них полностью нельзя, так как они являются неотъемлемой особенностью LLM. Галлюцинации — это то, что делает эти модели невероятно креативными, объяснил он.

С ним согласны и другие специалисты. «Как только действия модели ИИ становятся предопределенными, она начнет предсказывать то, что наиболее вероятно. В таком случае галлюцинации будут ограничены, но качество работы ИИ снизится, поскольку система всегда будет генерировать один и тот же текст», — отметила эксперт по ИИ из компании Siemens Мария Сухарева.

На самом деле нечестно требовать, чтобы у генеративных моделей ИИ не было галлюцинаций, потому что это именно то, чему мы их обучаем. Это их работа

«Это было довольно пугающе»

С галлюцинациями ИИ столкнулись не только пользователи Google.

В сентябре 2022 года известный американский физик и информатик Дуглас Хофштадтер рассказал, что они с коллегой решили позадавать бессмысленные вопросы большой языковой модели GPT-3, которая была разработана научно-исследовательской организацией OpenAI.

Например, Хофштадтер и его коллега поинтересовались у ИИ, что яичница-глазунья ест на завтрак. «Яичница-глазунья обычно ест тосты и фрукты», — такой ответ получили ученые. На вопрос, на сколько частей разобьется скрипка, если на нее уронить мармелад, GPT-3 заверил: «Скрипка разобьется на четыре части, если на нее уронить мармелад».

Я бы назвал ответы GPT-3 не просто невежественными, а абсолютно невежественными, то есть GPT-3 не понимает, что он понятия не имеет о том, что говорит. За GPT-3 нет никаких концепций; скорее существует просто огромное количество поглощенного текста, на основе которого он формулирует ответы

Фото: David Paul Morris / Bloomberg / Getty Images

А в феврале 2023 года внимание пользователей привлекла реклама чат-бота Google с искусственным интеллектом Bard (позднее был переименован в Gemini). В ролике система приписала телескопу «Джеймс Уэбб» первые съемки планет за пределами Солнечной системы. В комментариях указали, что на самом деле это сделал телескоп VLT (Very Large Telescope) в 2004 году.

В апреле того же года мэр одного австралийского города Брайан Худ обвинил чат-бот OpenAI ChatGPT в клевете. Поводом стала ложная информация о том, что чиновник в начале 2000-х годов отбывал тюремное заключение за взяточничество. Мэр отправил разработчику письмо с требованием удалить эти сведения и пригрозил подать в суд.

Также из-за «галлюцинаций ИИ» чуть не пострадала репутация известного американского адвоката Джонатана Терли, профессора юридического факультета Университета Джорджа Вашингтона. Как утверждал ChatGPT, юрист приставал к студентке во время поездки на Аляску. При этом в качестве источника значилась статья The Washington Post от 2018 года. Однако такой статьи никогда не существовало. Информация о домогательствах была полностью выдумана искусственным интеллектом.

Это было довольно пугающе. Обвинения такого рода невероятно вредны

А радиоведущий Марк Уолтерс из США был шокирован, когда узнал, что ChatGPT назвал его виновным в мошенничестве и растрате средств Фонда Второй поправки — некоммерческой организации, которая поддерживает права граждан на оружие. Ведущий никогда не работал на эту организацию и подал иск против OpenAI, суд уже начал рассматривать его дело.

Кто будет нести ответственность?

Галлюцинации ИИ могут быть ценным инструментом в творчестве, считает профессор компьютерных и информационных наук Пенсильванского университета Крис Каллисон-Берч. По его словам, благодаря глюкам искусственный интеллект может писать эссе и стихи, создавать музыку, изображения и видео, а также находить нестандартные решения задач.

Если я захочу воспроизвести свой собственный стиль письма, я могу найти примеры прошлых текстов, которые я написал, а затем попросить LLM повторить их в похожем стиле

Однако в некоторых случаях галлюцинации недопустимы — например, когда ИИ нужно поставить медицинский диагноз, дать финансовый совет или кратко изложить последние новости. В таком случае, как отметил Каллисон-Берч, любая неточность может не только приводить к проблемам, но и нести опасность для человека.

Фото: Denis Balibouse / Reuters

В связи с этим возникает вопрос: кто будет нести ответственность, если AI Overview кому-либо навредит? Согласно разделу 230 Акта о благопристойности при телекоммуникациях США 1996 года, интернет-компании, включая Google, освобождаются от ответственности за информацию, публикуемую на их платформах третьими лицами.

Скорее всего, IT-гигант cможет избежать наказания в случае, если кто-то из пользователей пострадает из-за советов ИИ. В описании к AI Overview предусмотрительно указано, что система может совершать ошибки

Сотрудники Национального университета Сингапура провели исследование, которое показало, что глюки ИИ вряд ли когда-нибудь удастся устранить. Как человек не может быть всегда прав, так и нейросеть будет допускать ошибки. «Всегда будет часть реального мира, которую LLM не сможет изучить и где у нее неизбежно будут возникать галлюцинации», — подчеркнули они.

Полностью устранить галлюцинации нельзя, однако можно найти способ ими управлять, считает профессор компьютерных наук Калифорнийского университета в Лос-Анджелесе Стефано Соатто. Он предлагает встроить модель в более крупную систему, которая будет проверять, являются ли достоверными сведения, которые ИИ выдает пользователю.

Если пользователи надеются скачать модель ИИ из интернета и запустить ее в надежде, что они получат фактические ответы на вопросы, то это неразумное использование модели, потому что она разработана и обучена не для этого. Но если они используют сервисы, которые помещают модель в более крупную систему, где можно указывать ограничения, то у этой системы не должны быть галлюцинаций